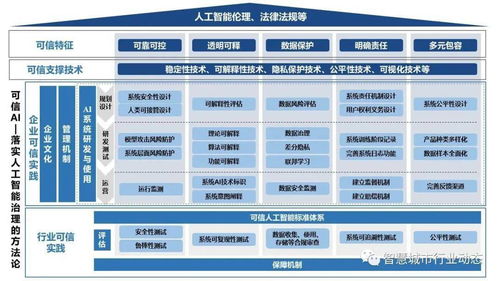

隨著人工智能技術的深度滲透與廣泛應用,構建安全、可靠、可控的“可信人工智能”已成為業界共識與迫切需求。作為實現可信AI的核心載體,人工智能基礎軟件(尤其是AI框架)在其中扮演著樞紐角色。一個真正“可信”的AI框架,不僅需要提供高效的模型開發與訓練能力,更需內嵌一套完整的技術體系來保障其全生命周期的可信賴性。本文將深入解析支撐可信AI框架的四大關鍵技術,并探討其實踐路徑。

一、四大支撐技術

- 安全與隱私保護技術

- 核心技術:這主要包括聯邦學習、差分隱私、同態加密與安全多方計算。聯邦學習使得數據可以“可用不可見”,在本地進行模型訓練,僅交互加密的模型參數更新,從而保護原始數據隱私。差分隱私通過在數據或查詢結果中添加可控的隨機噪聲,防止從模型輸出中反推個體信息。同態加密允許在密文狀態下直接進行計算,而安全多方計算則使多個參與方能在不泄露各自私有輸入的前提下,共同完成函數計算。

- 在框架中的體現:可信AI框架需將這些技術作為基礎算子或專用模塊進行集成,提供標準化的API,使開發者能夠便捷地將隱私保護能力嵌入到數據預處理、模型訓練與推理的各個環節。

- 魯棒性與可解釋性技術

- 核心技術:對抗性魯棒性旨在提升模型抵御精心設計的對抗樣本攻擊的能力,技術包括對抗訓練、輸入凈化等。可解釋性技術則致力于揭開模型“黑箱”,包括基于特征歸因的方法(如SHAP、LIME)、可視化工具以及生成易于理解的決策規則或自然語言解釋。

- 在框架中的體現:框架應內置對抗樣本生成與檢測工具、魯棒性訓練接口,并提供模型診斷儀表盤,可視化展示特征重要性、決策路徑及潛在的偏見來源,輔助開發者理解、調試并加固模型。

- 公平性與偏見消減技術

- 核心技術:涉及公平性度量(如 demographic parity, equal opportunity)、偏見檢測與消減算法。通過在數據層面(重采樣、重加權)、算法層面(如 adversarial debiasing)或后處理層面調整決策閾值,來減少模型對特定敏感屬性(如性別、種族)的歧視性偏差。

- 在框架中的體現:可信AI框架需要集成公平性評估指標庫,提供從數據審計到模型訓練、評估、校正的全流程工具鏈,自動化或半自動化地幫助識別和緩解不公平性。

- 可控與可追溯的治理技術

- 核心技術:主要指模型版本管理、數據譜系追溯、全生命周期監控以及符合倫理規范的約束嵌入。利用區塊鏈等技術實現關鍵操作(如數據使用、模型更新)的不可篡改記錄。

- 在框架中的體現:框架需與MLOps平臺深度結合,提供完善的元數據管理、實驗追蹤、模型注冊和部署監控功能。確保從訓練數據來源、參數配置、到模型部署后性能漂移的每一個環節都可審計、可追溯、可回滾。

二、實踐路徑

構建與落地可信AI框架并非一蹴而就,需要遵循系統化的實踐路徑:

- 分層融入,標準先行:將上述四大技術能力以“基礎層算子(如加密原語)- 中間件組件(如聯邦學習模塊)- 頂層工具鏈(如可視化審計工具)”的分層架構融入框架設計中。積極采納和參與制定行業與國家標準(如IEEE、ISO相關標準),確保技術實踐的規范性與互操作性。

- 開發運維一體化(DevSecOps for AI):將可信性要求貫穿于AI系統的整個開發運維(DevOps)周期,形成“AI DevSecOps”。在需求設計階段即引入隱私、公平性影響評估;在開發階段利用框架內置工具進行安全編碼與測試;在部署與運維階段持續監控模型性能與可信指標。

- 場景驅動,漸進式實施:針對不同應用場景(如金融風控、醫療診斷、自動駕駛)的風險等級與監管要求,優先實施最關鍵的可信技術。例如,金融領域優先強化隱私保護與可解釋性;公共決策領域則優先保障公平性與可追溯性。從試點項目開始,積累經驗后再逐步推廣。

- 生態共建,開放協作:可信AI的實現需要算法研究者、框架開發者、行業用戶、法律與倫理專家的多方協作。開源框架應建立開放的治理社區,鼓勵貢獻可信功能模塊、共享最佳實踐案例,并建立第三方審計與認證機制,共同推動可信AI生態的繁榮。

###

可信AI框架是人工智能行穩致遠的“壓艙石”。其四大支撐技術——安全隱私、魯棒可解釋、公平無偏見、可控可追溯——共同構成了一個相互關聯、彼此增強的技術矩陣。通過分層融入、標準引領、全周期治理、場景化落地與生態協作的實踐路徑,我們能夠穩步推進可信AI從理論原則走向工程現實,最終讓人工智能技術真正造福社會,贏得廣泛信任。